Report

Sensoren

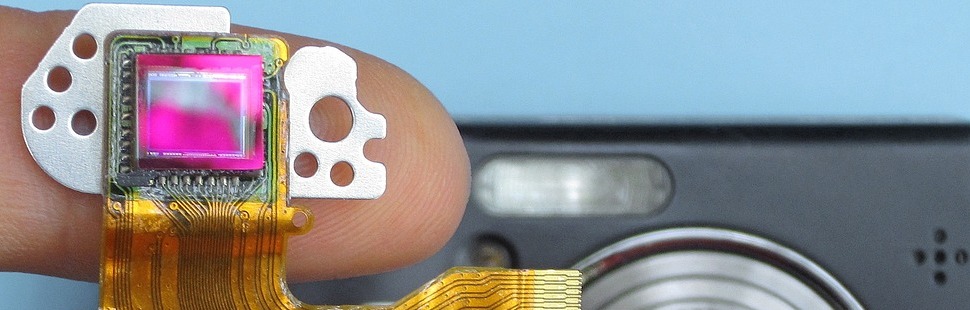

Bildsensoren haben die Fotografie revolutioniert. Der Artikel stellt ihre Ursprünge, Bauweisen und nicht zuletzt ihre Vor- und Nachteile vor.

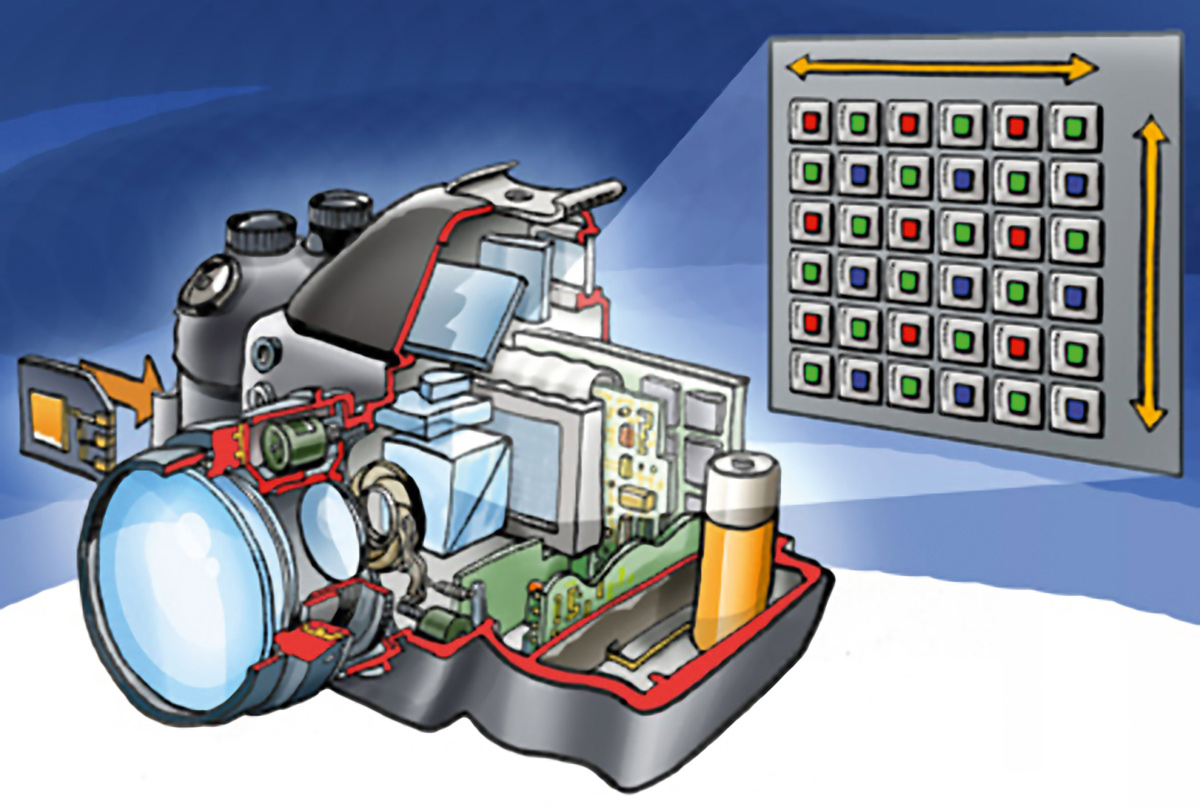

Die Fotografie verdankt ihre „digtale Revolution“ einem Bauteil, das im engeren Sinne analog arbeitet: Die Bildsensoren basieren darauf, dass ihr Halbleitermaterial auf Siliziumbasis bei Lichteinfall einen elektrische Spannung abgibt. Mit stärkerem Lichteinfall steigt dieser Spannungswert an, sodass man die auf den Sensor fallende Helligkeit messen kann.

Bei einem Bildsensor sind die lichtempfindlichen Flächen in ein Raster aus Millionen von Einzelflächen unterteilt, die den so genannten „Pixel“, also den Bildpunkten entsprechen. Um zu einem Digitalbild zu werden, müssen die durch das Licht erzeugten Spannungsschwankungen für jeden Bildpunkt einzeln erfasst und mittels eines „Analog-Digital-Wandlers“ in ein für den Computer verständliches digitales Zahlenformat übersetzt werden.

Farbe ins Bild

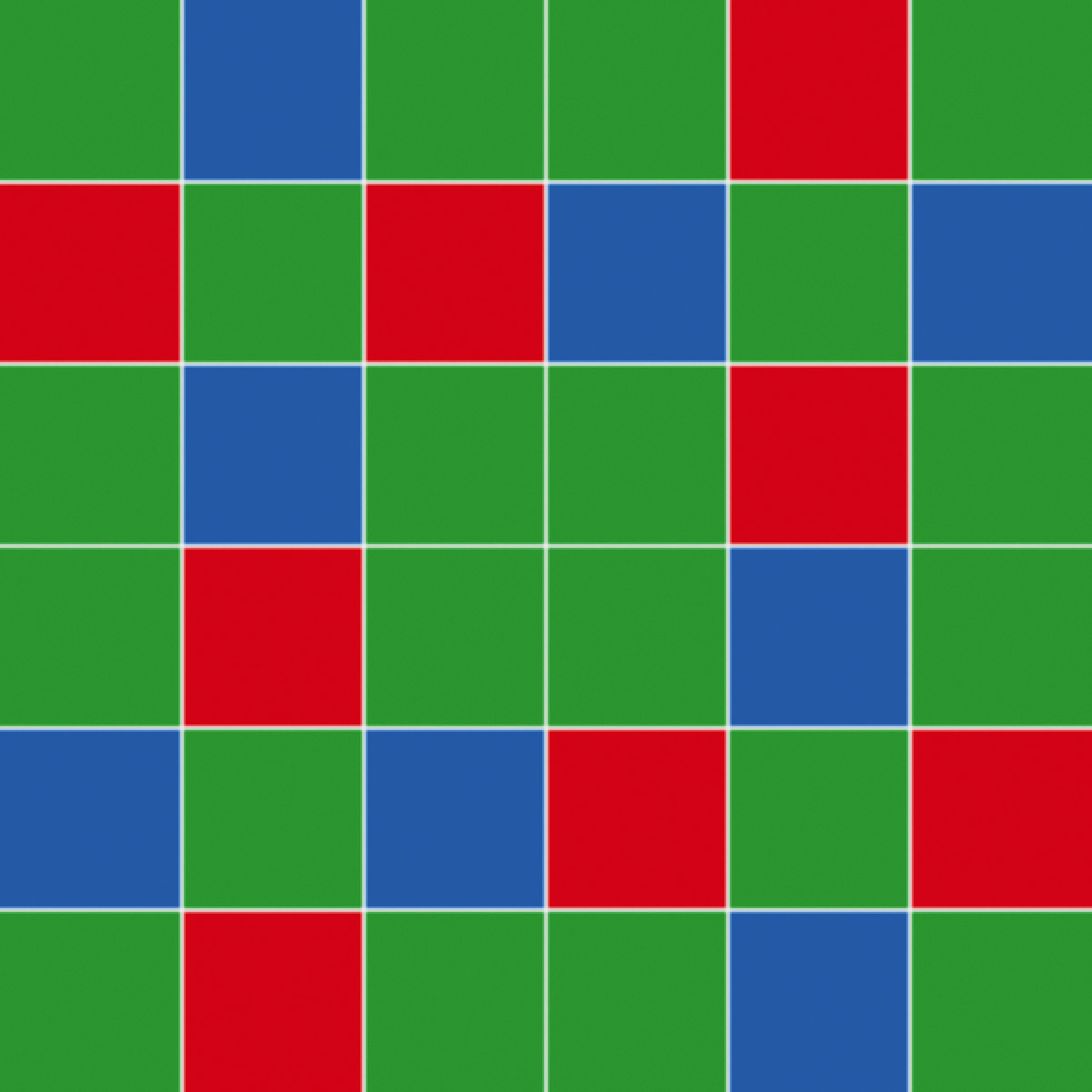

Aber auch dann ist das Foto noch nicht fertig, denn es besteht nur aus Helligkeitsabstufungen, also Grauwerten – es ist also ein „Schwarz-Weiß-Foto“. Um zu einem bunten Bild zu kommen, greifen die Hersteller zu einem Trick. Vor jedem einzelnen Pixel auf dem Sensor wird ein winziger Farbfilter in den drei Grundfarben RGB aufgebracht, sodass dieser Bildpunkt die Helligkeitsabstufungen nur für jeweils rote, grüne oder blaue Elemente des Motivs erfasst. Die Anordnung der Rot-Grün-Blau-Filter entspricht dabei fast immer der „Bayer-Matrix“, hat also in der ungeradzahligen Zeile Grün-Blau-Grün-Filter, in den geradzahligen Zeile dann Rot-Grün-Rot-Filter und so weiter.

Jeder Bildpunkt eines Digitalfotos kann aber eine von etwa 16,8 Millionen Farbtönen enthalten, die erst aus der Mischung aus Rot, Grün und Blau entsteht (256 Rot-Nuancen × 256 Grün-Nuancen × 256 Blau-Nuancen ergibt 16.777.216 Farbkombinationen). Der Chip kann also selbst mit den Filtern zunächst noch kein Farbfoto erzeugen, sondern benötigt die Hilfe eines kleinen Computers, des so genannten „Bildprozessors“. Er erhält zum Beispiel die fehlenden Grün- und Blau-Informationen für ein Rotfilter-Pixel von dessen benachbarten Punkten, um die RGB-Gesamtinformation errechnen zu können. Dieser Prozess wird als „Farbinterpolation“ bezeichnet.

Sonderformen

Bei den Sensoren gibt es Bemühungen, durch ein verändertes Farbraster diese Berechnung zu verbessern. Fujifilm etwa verwendet bei seinen Spitzenmodellen die X-Trans-CMOS-Technik. Hier sind in der ersten Zeile die Farben gemäß dem Schema Grün, Blau, Grün, Grün, Rot, Grün und in der zweiten Zeile Rot, Grün, Rot, Blau, Grün, Blau angeordnet. In den Folgezeilen werden andere Muster verwendet, sodass sich innerhalb einer Pixel-Matrix von sechs mal sechs Pixel ein unregelmäßiges Farbmuster ergibt, mit dem sich feine Strukturen natürlich wirkender erfassen lassen.

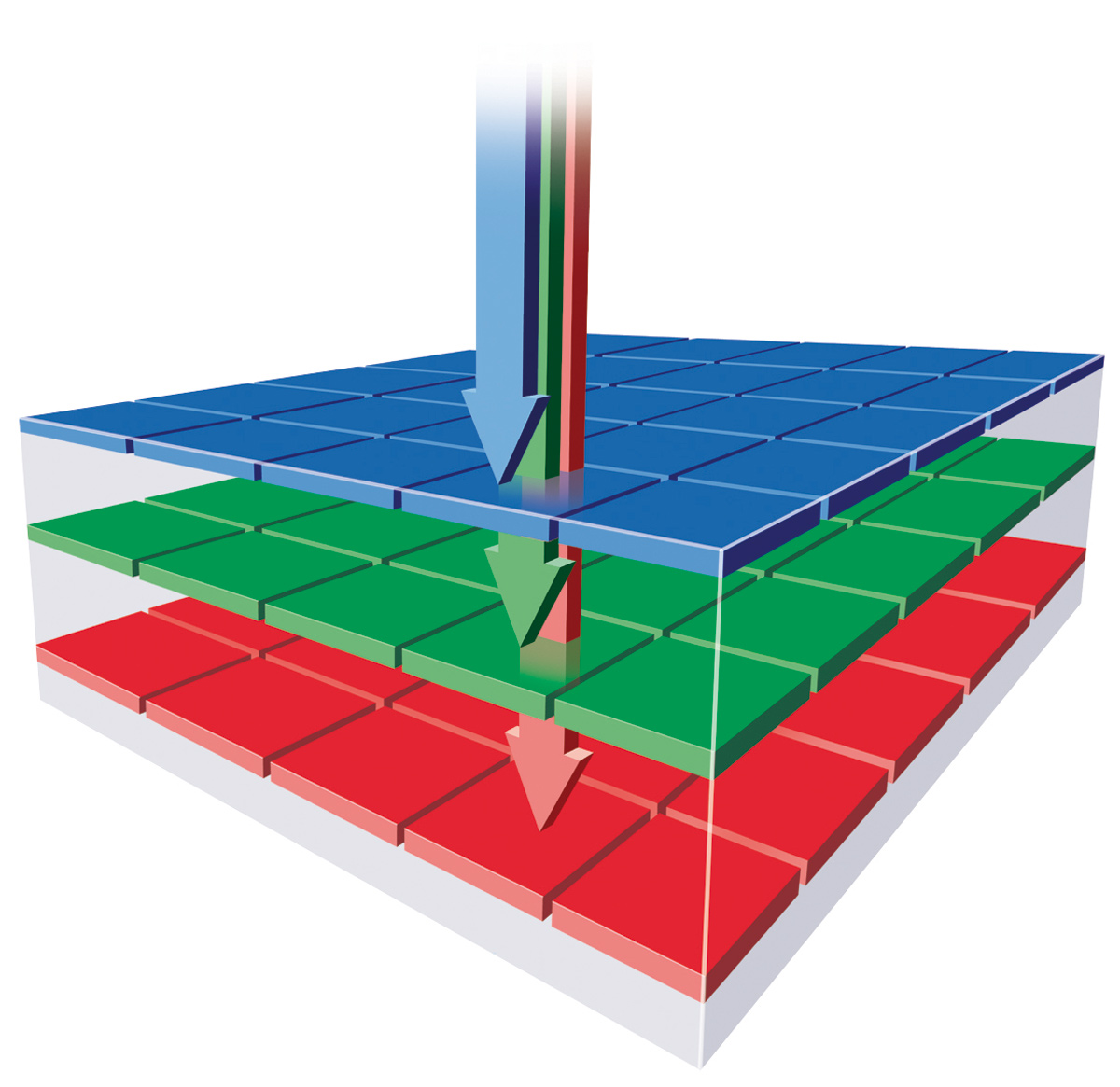

Die einzige Ausnahme unter den Sensoren, die für jeden Bildpunkt eine komplette RGB-Farbinformation ermittelt, bilden die von Sigma produzierten „Foveon“-Sensoren. Sie nutzen die Eigenschaft des Lichts, dass die Wellenlängen für Rot, Grün und Blau in unterschiedlichen Schichten des Sensors getrennt erfasst werden können.

CCD und CMOS

Die ersten Bildsensoren wurden als CCDs, also „Charged-Coupled Device“ oder „Ladungsgekoppeltes Bauteil“ bezeichnet. Sie kamen bereits in den 1970er Jahren etwa in Fernsehkameras zum Einsatz und werden heute in der Astronomie-Fotografie eingesetzt.

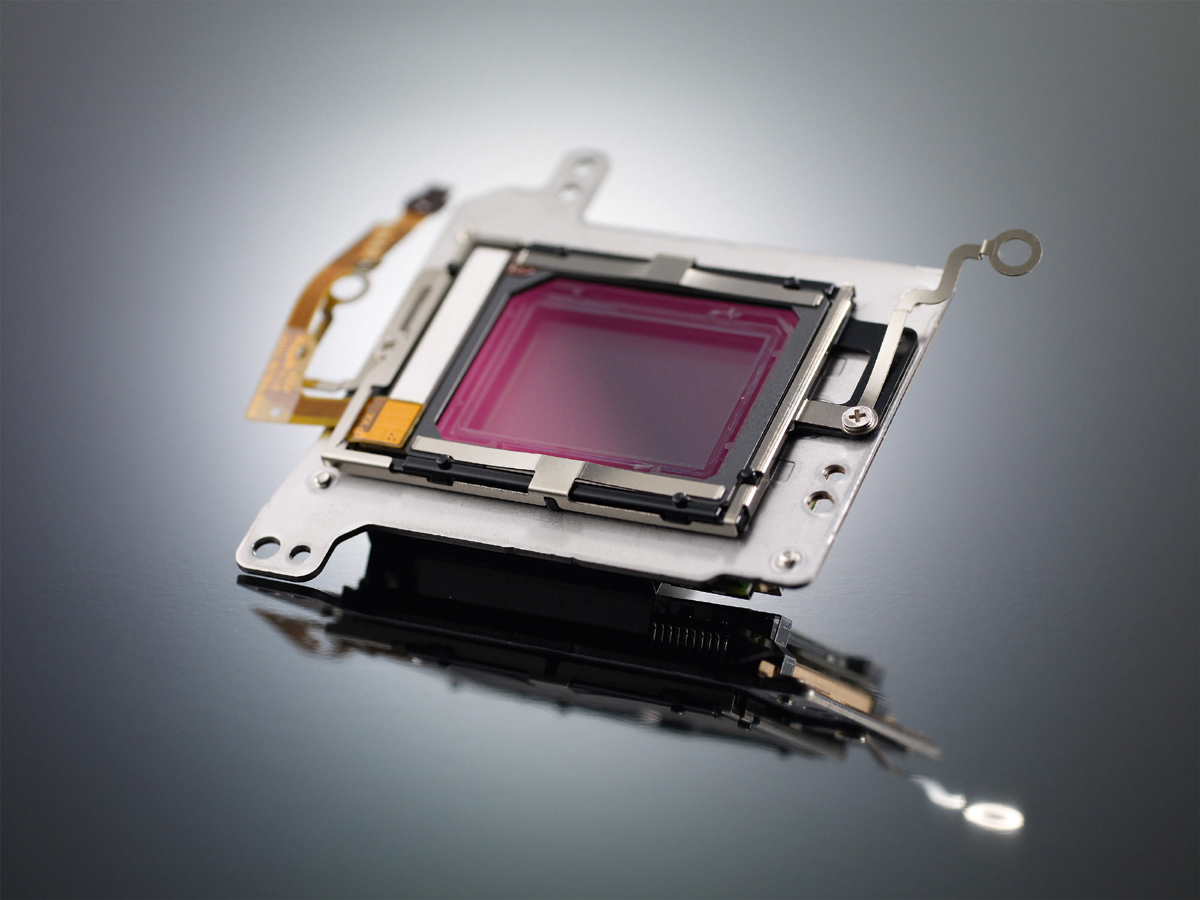

Die aktuellen Digitalkameras basieren dagegen in der Regel auf CMOS-Technik („Complementary Metal-Oxide Semiconductor“). Das grundsätzliche Prinzip der Bilderfassung durch einen lichtempfindlichen Halbleiter entspricht dem der CCDs, aber die CMOS-Sensoren sind etwas anders als diese aufgebaut. Bei den modernen CMOS-Lösungen handelt es sich eigentlich um elektronische Bausteine ähnlich einem Prozessor, die durch die lichtempfindliche Siliziumschicht beziehungsweise Aufnahmefläche erweitert wurden. Sie bieten daher die Möglichkeiten zur direkten Datenaufbereitung.

Sensorgrößen

Neben der Bildauflösung in Pixel liegt eines der wichtigsten Kriterien für Kameraklassen in der Sensorgröße begründet. Während beim analogen Kleinbildfilm die Aufnahmefläche von 36 mal 24 Millimetern durch das standardisierte Filmformat quasi genormt war, sind digitale Bildsensoren nämlich in vielen verschiedenen Größen erhältlich.

Der Grund dafür liegt in ihrer technischen Herstellung: Je größer die Aufnahmefläche ist, desto fehleranfälliger und daraus folgernd teurer wird der Chip. Die Kostensteigerung läuft nicht linear ab, sondern wächst bei einer Verdoppelung der Fläche exponentiell auf ein Vielfaches des ursprünglichen Preises. Im Gegenzug hat der größere Sensor den Vorteil, dass auch seine einzelnen Pixelzellen mehr Fläche besitzen, was sie lichtempfindlicher und weniger anfällig für das Bildrauschen macht. Die Hersteller müssen also einen Kompromiss zwischen maximaler Bildqualität und günstigem Preis eingehen.

So gehören die Bildsensoren heutiger Kompaktkameras üblicherweise der 1/2,33-Zoll-Klasse an. Ihre Aufnahmefläche beträgt etwa 6,2 mal 4,6 Millimeter, ihre Bilddiagonale 7,7 Millimeter.

Wer nun zum Taschenrechner greift und versucht, aus der 1/2,33-Angabe mit einem Maßstab von 25,4 Millimeter für „ein Zoll“ diese Größenangabe nachzurechnen, wird Fehler feststellen. Tatsächlich beträgt die „Zoll“-Größe bei Bildsensoren nämlich nur etwa 16 Millimeter. Das liegt daran, dass ihre Größenangaben noch auf der Bildfläche analoger Fernsehröhren beruht. Diese Vakuumglasröhren hatten zwar eine äußere Diagonale von einem Zoll, ihre Aufnahmefläche im Inneren war aber kleiner (etwa 16 Millimeter Diagonale). Diese „Zoll“-Angaben haben die Hersteller digitaler Aufnahmesensoren leider übernommen, sodass es zu dem Umrechnungswirrwarr kommt.

Viele SLR-Kameras nutzen dagegen Vollformatsensoren, die dem Kleinbildfilm von 36 mal 24 Millimetern entsprechen und die ebenfalls gebräuchliche Bezeichnung als „Kleinbild-DSLR“ erklären.

Wegen deren hohen Produktionskosten haben sich bei digitalen Systemkameras weitere Sensorgrößen etabliert. Einsteiger- und Mittelklasse-Modelle nutzen Aufnahmechips in „APS-C“-Größe. Hier kommt der analoge APS-Film mit 25,1 mal 16,7 Millimetern als Vergleichsmaßstab zum Einsatz. Die „APS-C“-Größe der Sensoren wird von den Herstellern jedoch sehr frei ausgelegt. Bei Canon beträgt sie etwa 22,5 mal 15 Millimeter, bei Nikon 23,5 mal 15,7 Millimeter. Der Begriff „APS-C“ ist daher als eine Kameraklasse statt als echte Sensorgröße zu verstehen.

Das „APS-C“-Format wird von auch von spiegellosen Systemkameras wie etwa von Fujifilm, Sony oder Samsung genutzt. Daneben gibt es bei den CSC/DSLM-Modellen die Micro-Four-Thirds-Produkte. Die von Olympus und Panasonic eingesetzten Sensoren in ihren „MFT“-Kameras besitzen eine Größe von 17,3 mal 13 Millimetern. Nikon verwendet für seine 1-Serie das Ein-Zoll-Format mit 13,2 mal 8,8 Millimetern.